Comment Google indexe t-il nos contenus, et quels sont les freins au crawling ? Matt Cutts nous répond.

(article traduit de l'anglais - merci à Rand Fishkin pour l'autorisation)

[début de l'article original]

Eric Enge, de Stone Temple, a publié une interview de Matt Cutts (le "chef anti spam et contenu dupliqué" de Google). Je pense que toute la communauté SEO sera d'accord sur le fait que le temps passé par Matt lors de ce type d'interviews est phénoménal, et que nous ne pouvons qu'espérer avoir l'occasion de le revoir dans le futur.

Mieux comprendre les points de vu de Google, leur technologie et leurs buts ne peut qu'améliorer le travail des créateurs de sites Internet et des chargés de webmarketing. L'interview en lui-même vaut le détour, mais un des lecteurs de SeoMoz m'a fait remarquer par email qu'il n'avait pas pu le consulter en entier. Nous allons donc décrire les principaux points énoncés par Matt avec des graphiques. J'y ais aussi inclut mes propres interprétations ainsi qu'un peu de fun. Seules les textes entre guillemets sont des citations directes de Matt Cutts, donc gardez en tête que c'est ma vision de ses propos.

L'indexation, par Google

La limite d'indexation

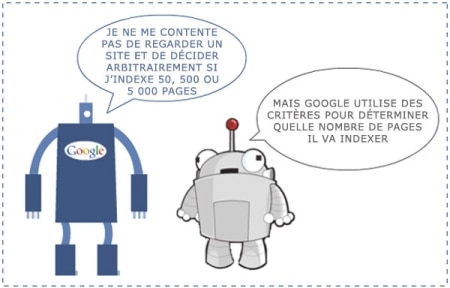

Il n'y a pas de limite d'indexation, mais l'indexation a des limites

De nombreux critères sont utilisés pour savoir quoi indexer dans Google

Duplicate content

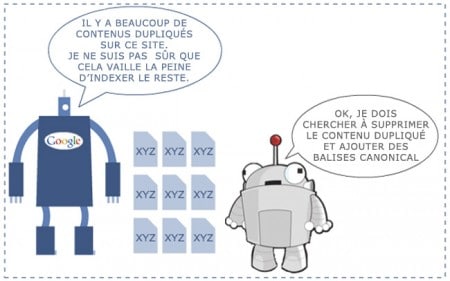

Le contenu dupliqué peut bloquer votre indexation

Un contenu dupliqué nuit à l'indexation

Impact du pagerank

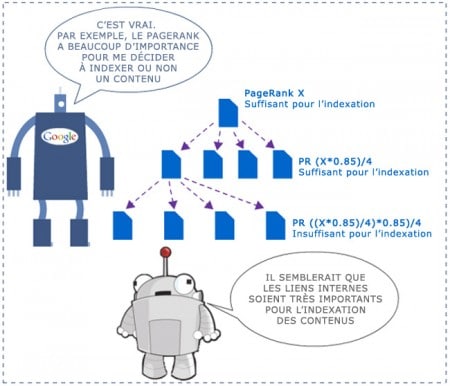

Le pagerank influe t-il sur l'indexation ?

Le pagerank est un critère important pour l'indexation des contenus par Google

Indexation et affiliation

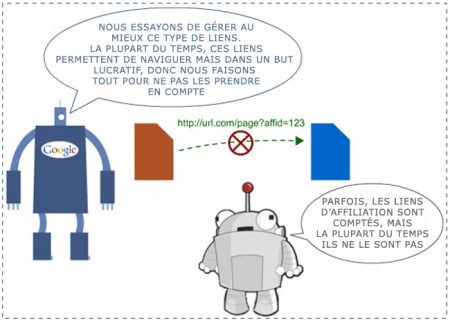

Les liens des affiliés sont-ils pris en compte ?

Les liens d'affiliation ne transmettent que rarement le pagerank

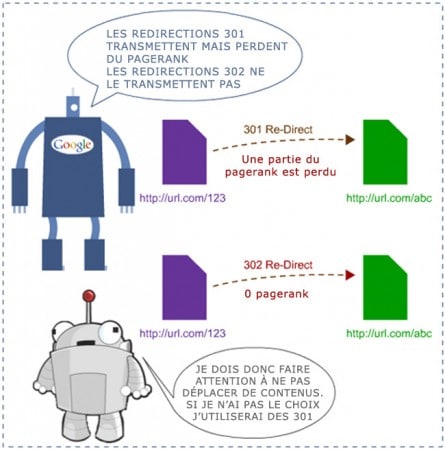

Redirections 301 et 302

Les redirections 301 transfèrent une partie seulement de la popularité

Les redirections 301 transmettent une partie du pagerank, et les 302 n'en transmettent pas du tout

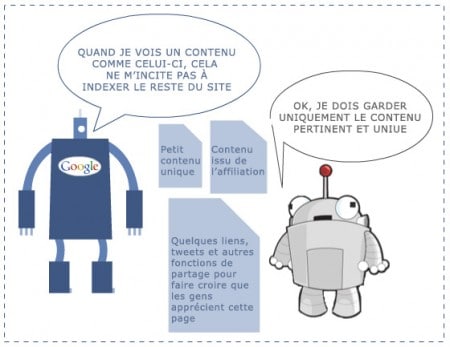

Qualité du contenu

Les pages pauvres en contenu ou dupliquées réduiront votre indexation

Un contenu unique est vital pour l'indexation d'un site

Navigation & PageRank Sculpting

Navigation multiple et PageRank Sculpting sont des problèmes épineux...

Le pagerank sculpting ne sert à rien : pensez à vos visiteurs

Des avis sur l'indexation de Google

Personnellement, j'ai beaucoup apprécié comment Eric à poussé Matt à expliquer des scénarios qui nécessitent d'afficher une navigation ou un contenu différent entre l'utilisateur et moteur de recherche. Cependant, je comprends Matt Cutts qui doit prendre position pour que ce qu'il dise soit vrai des 95% des cas, sans créer de problèmes chez ceux qui tenteraient d'appliquer sur leur site une méthode qui ne leur convient pas.

Un autre élément m'a fait bondir :

Matt Cutts : (au sujet des liens dans les publicités) notre point de vu n'a pas changé sur ce point, et nous devrions d'ailleurs donner des possibilités supplémentaires de faire un spam report dans les mois à venir. Nous avons de nouvelles technologies qui seront bientôt en ligne pour combattre ce problème, et nous devrions mettre aussi en place un feedback pour tous les liens de type spam.

Cela s'annonce bien : un des grandes frustrations du monde SEO est de percevoir ses concurrents comme étant surclassés grâce à des techniques black hat, et qui doivent faire de même pour rester dans la compétition. Mettre un terme à cette pratique ou faire sentir aux SEO que Google prend à bras le corps le problème mettra cependant longtemps à se mettre en place.

Ma dernière recommandation est de vérifier les 29 points clés d'Eric lors de l'interview de Matt Cutts (voir sources), qui résument pas mal d'informations et de désinformations qui circulent sur la manière dont Google indexe le contenu.

[fin de l'article d'origine]

L'article de SeoMoz est plutôt bon, mais je ne suis pas forcément d'accord avec tout ce qui est dit.

Déjà, j'apprécie assez moyennement la relation entre "technique black hat" et "mauvaise technique". Le SEO black hat, c'est avant tout savoir fouiner et automatiser une partie des tâches. Vous aurez ainsi d'excellents référenceurs black hat, et de très mauvais.

En ce qui concerne l'affiliation, je vois mal comment Google pourra réussir à détecter les liens d'affiliation. Parfois, l'url n'est même pas codée via la plateforme et ressemble fortement à un lien traditionnel (cookie contenu dans une image par exemple). Idem dans le cas de la vente d'espace publicitaire. Donc je suis très prudent sur le fait que le méchant Google va venir taper sur les doigts des webmasters qui vendent des espaces publicitaires ou de l'affiliation sans la balise nofollow.

Je confirme ce qui est dit sur le frein provoqué par le contenu dupliqué sur un site. Par contre, je ne suis pas trop d'accord sur l'importance du pagerank dans l'indexation. Certes, les forts pageranks seront crawlés plus souvent, mais les petits peuvent l'être tout autant avec du contenu renouvelé fréquemment et quelques backlinks bien placés.

A mon avis, la structure du site et le contenu dupliqués sont les seuls vrais freins à l'indexation auxquels il faut rajouter des éléments techniques qui peuvent se retourner contre un site, comme le robots.txt, les redirections ou les balise meta index/noindex.

Je confirme aussi que les redirections 301 perdent une partie du pagerank. Lisez d'ailleurs le très bon article d'Axe-Net sur les redirections 301. Lisez également mon article sur la transmission du pagerank.

N'hésitez pas à me/le contredire en donnant votre avis. ;)

Sources sur l'indexation de contenus

- An illustrated guide to Matt Cutt's commentson Crawling and Indexation (Seomoz)

- 29 tidbits from Matt Cutts Interview (Stonetemple)

- Interview de Matt Cutts (Stonetemple)

17 Commentaires

La solution à mon problème se trouve sans doute dans cette page.

Non pas des contenus dupliquées mais des url diffèrents pour arriver à la même page, ceci est du aux divers outils et composants de mon site sous joomla.

Je vais m'y attarder

Merci

Parmi les audits que je réalise, l'architecture du site est le plus souvent coupable d'empêcher une bonne indexation. C'est une perte de potentiel de visibilité énorme lorsqu'une majorité du site n'est même pas indexée.

Le dup content est tout de même moins problématique de nos jours. Dans sa version interne en tout cas.

En tout cas, bien ton billet ;)

Merci, toutes ces infos sont très utiles, ont va les utiliser à bon escient pour notre site de e-commerce

Merci pour cette traduction. J'avais déjà remarqué plusieurs éléments comme le PR de la barre verte étant un indicateur de la non indexation d'une page. A partir de cet élément, on peut ne chercher les causes.

Arpès, il est clair que Matt Cutts doit prendre position et s'y tenir. C'est pourquoi, parfois, ces réponses ne sont pas toujours limpides ;)

J'ai pas tout compris. Mais je préfère les entrailles de dinde... c'est plus sûr ! ;+)

Le contenu dupliqué reste un mystère pour moi, j'ai un site de paroles de chansons qui semble en souffrir, mais certains de mes concurrents n'en souffrent aucunement, une histoire de pagerank? Mon site est pourtant PR4!

Le cas des sites de chansons doit être l'un des pires cas de duplicate content sur le web. Ce qu'il faut, c'est générer le plus de backlinks de qualité pour démontrer à Google la pertinence du contenu face aux autres sites du même genre. Il faut surtout trouver des backlinks sur les pages profondes (plusieurs pour chaque chanson est alors l'idéal).

"Les 302 n'en transmettent pas du tout de pagerank (de jus, de positionnement)"

Ouais, c'est ce qu'on nous fait croire, parce que dans certains cas... ;)

Hum...

Je suis très perplexe face au fait que les liens d'affiliation ( sous la forme d'un lien traditionnel ) ne transmettent pas ou moins de jus qu'un lien classique...

Le contenu dupliqué influence négativement le positionnement du site, depuis 4 semaines j'ai référencé un site dont les pages sont dupliqués et le client n'était pas convaincu de changer le contenu des pages, j'ai effectué un travail énorme mais aucune résultats positive....

Article intéréssant.

Je vois souvent écrit que les problèmes d'indexations peuvent venir d'une mauvaise structure de site, d'une mauvaise architecture de pages... mais concrètement, c'est quoi une bonne, et une mauvaise structure ? Y'a-t-il des articles sur le sujet ? (articles un peu poussés si possible... pas juste conseiller de mettre du h1, mettre des alt, ou avoir un pertinent... )

La présentation par l'image est très sympa :)

Sinon, il n'y a pas grand chose à se mettre sous la dent. Ce n'est que de la logique : Contenu dupliqué, peu de contenu, effet modéré du PR ... etc.

Depuis que je me passionne pour le référencement (4 ans environs) et que je lis les interventions de Matt Cutts, j'en arrive toujours à la même conclusion pour bien référencer un site (en mettant de coté les techniques BH) :

Du coté de la rédaction

- Création d'articles uniques quotidiennement

- Articles apportant un plus par rapport à la concurrence

- Articles avec beaucoup de contenu

- ...etc.

Du coté de la technique

- Structure optimisée pour les liens internes

- Structure logique pour la navigation de l'internaute

- ... etc.

En suivant ces quelques règles, cela marchera bien pour le site.

Je trouve cela très simple le SEO en théorie mais dans la pratique, c'est super dur car cela demande beaucoup de veille, un gros travail de rédaction et une ténacité à toute épreuve pour ne pas ralentir la production. Personnellement, je n'y arrive pas :(

D'ailleurs cela me fait penser que je dois faire un article sur ce sujet ce matin.

Joli dessins, nous retwittons -)) Bravo pour cet article pertinent. En début de semaine, VOLUMIUM publiera un nouvel article sur les redirections 302 !!

A lire sur volumium.fr donc !!

Merci pour cet article. Néanmoins rien de bien neuf, mais des confirmations qui font plaisir à entendre: faites les choses proprement et dans les règles (grosso modo), votre SEO n'en ressortira que meilleur !

Excellent article, Matt explicite l'ensemble des éléments pour les non-initiés, mais reste vague sur les sujets qui nous intéressent d'avantage comme une partie de l'algo qui répertorie l'importance des éléments participent à la vitesse d'indexation d'un nouveau site...

Toutefois l'article est comme d'habitude, d'une qualité remarquable.

« A mon avis, la structure du site et le contenu dupliqués sont les seuls vrais freins à l'indexation »

Ce sont les 1ers freins mais le code en est un aussi (sans parler de contenu en Flash)

Je restes comme toujours assez circonspect avec une partie de ce que dit Matt Cutts mais bon dans l'ensemble on va dire que j'adhere plutot avec ce qui est dit

Laisser un commentaire